GNU Wget è un pacchetto software gratuito per il download di file tramite HTTP, HTTPS e FTP, i protocolli Internet più diffusi. E’ uno strumento non interattivo a riga di comando, può essere facilmente chiamato da script, lavori programmati con cron , in terminali senza supporto per X-Windows, ecc

GNU Wget è un pacchetto software gratuito per il download di file tramite HTTP, HTTPS e FTP, i protocolli Internet più diffusi. E’ uno strumento non interattivo a riga di comando, può essere facilmente chiamato da script, lavori programmati con cron , in terminali senza supporto per X-Windows, ecc

GNU Wget ha molte caratteristiche per rendere il recupero di file di grandi dimensioni o mirroring di tutto un sito web o di un sito FTP facile ecco alcune interessanti opzioni.

Tutti questi comandi vanno dati da terminale linux.

Utilizzo base, scaricare un pacchetto conoscendo la sua URL http (o ftp):

wget http://kernel.org/pub/linux/kernel/v2.6/patch-2.6.23.bz2

Utilizzo di wget per un download ricorsivo

wget-r http://my.site.todownload.com/

Il comando -r dice a wget di scaricare ricorsivamente tutto dall’URL indicato.

Utilizzo di Wget per un download ricorsivo, ma limitando il numero dei livelli a 2

wget-r-l2 http://my.site.todownload.com/

Il -r fa la stessa cosa del precedente esempio, ma -l dice a wget di limitare a quel numero di livelli di profondità il download in questo caso due livelli (il default altrimenti è 5)

Utilizzo di Wget per un download ricorsivo, ma limitando il tipo di file che si desidera scaricare

wget-r-a.pdf-R.htm http://my.site.todownload.com/

Questo dice a wget di fare un download ricorsivo e accetta tutti i file con estensione .pdf e scarta tutti i file con estensione .htm

Utilizzo di Wget per un download ricorsivo da un sito FTP con autenticazione

wget -r ftp://username:[email protected]/path/to/download

Questo dice a wget di fare un download ricorsivoe da FTP con username e password

Utilizzo di Wget per controllare link non funzionanti sul vostro sito

wget --spider -r -o log.txt http://yourdomain.comIn questo esempio diciamo a Wget di agire come uno spider web (Wget si comporterà come un spider Web, il che significa che non scaricherà le pagine, controllerà solo ì link siano funzionanti), e metterà i risultati nel file log.txt, in questo modo è possibile aprirlo ad operazioni terminate e cercare la lista dei link non funzionanti.

Utilizzo di Wget per scaricare una galleria di foto

for i in `seq -w 1 100`; do wget "http://www.mysite.com/images/DSCF00$i.jpg"; done

In questo esempio si esegue un ciclo che va da 1 a 100 e ogni volta si scarica una URL diverso (rappresentante una foto diversa), davvero utile per scaricare rapidamente una galleria senza link.

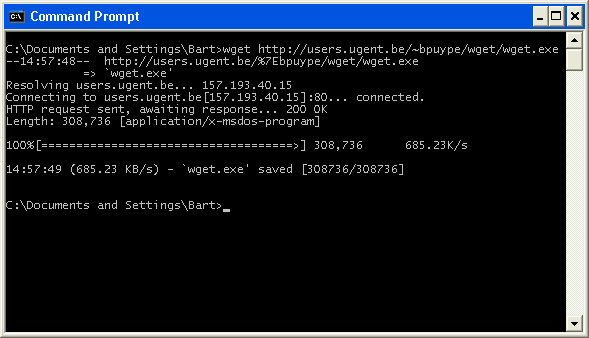

Infine, dimenticavo di dirvi che wget è utilizzabile anche da Mac e Windows (richeide cygwin)

E fatemi sapere se avete utilizzate wget in maniera fantasiosa

Popular Posts:

- None Found